Samsung ha anunciado la disponibilidad de una nueva funcionalidad para los dispositivos de la serie Galaxy S25: Gemini Live, un sistema de inteligencia artificial que permite interacciones visuales en tiempo real. A partir del 7 de abril, todos los usuarios de esta gama podrán acceder gratuitamente a esta actualización, que introduce capacidades conversacionales potenciadas por visión computacional, según ha informado la compañía.

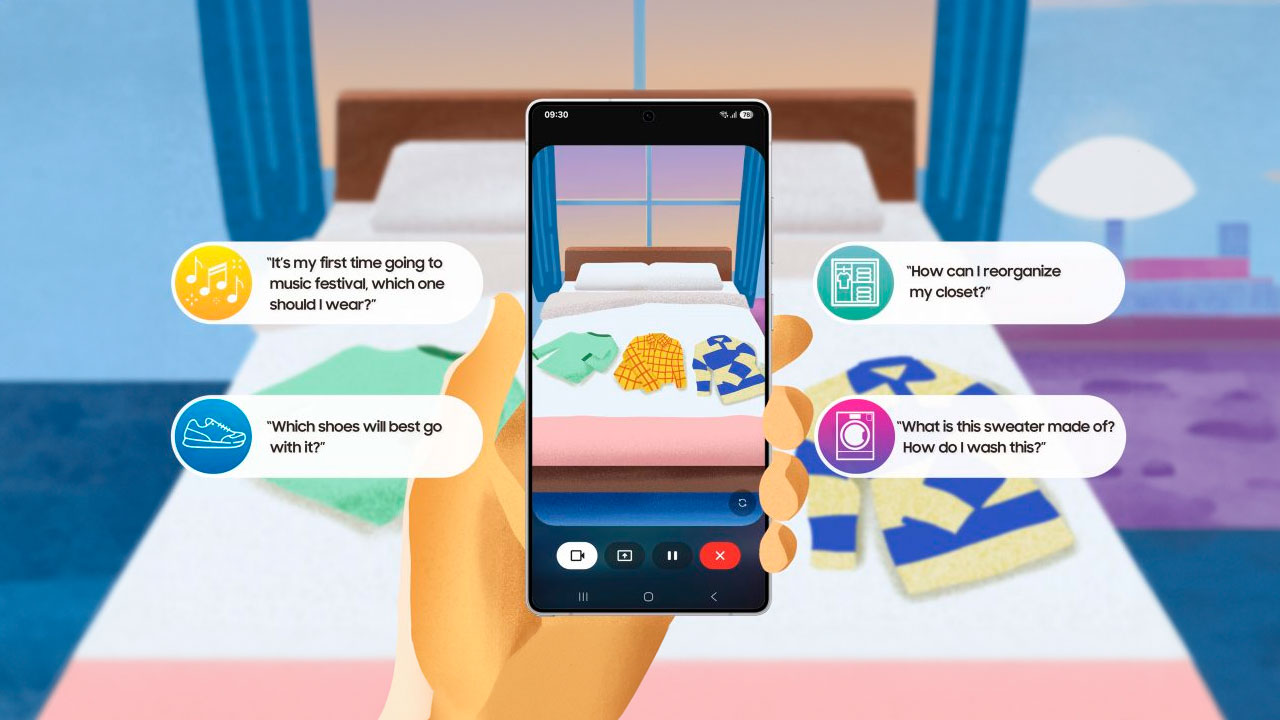

La nueva herramienta, desarrollada en colaboración con Google, permite a los usuarios mantener una conversación directa con el asistente de IA mientras muestran, mediante la cámara o la pantalla, elementos de su entorno o actividades digitales. Esta implementación está diseñada para facilitar tareas cotidianas a través de respuestas visuales instantáneas del sistema.

Según el comunicado oficial, basta con mantener pulsado el botón lateral del terminal para iniciar Gemini Live, que puede analizar el contenido captado por la cámara o la actividad mostrada en pantalla mientras responde verbalmente al usuario. Fuente: Samsung Electronics.

Gemini Live: interacción visual aplicada a tareas domésticas y decisiones cotidianas

Entre los ejemplos de uso que ha señalado la compañía se encuentra la selección de ropa o la organización del armario. Al mostrar estos elementos a través de la cámara, Gemini Live ofrece sugerencias sobre clasificación, orden o elección de prendas. También es posible compartir la pantalla del dispositivo mientras se navega por tiendas online, con el objetivo de obtener recomendaciones de estilo en función del contenido visualizado.

Estas funciones operan en tiempo real y se articulan en torno a modelos de lenguaje multimodal capaces de interpretar imágenes y textos simultáneamente. La integración de Gemini Live en la serie Galaxy S25 supone un paso hacia la implementación generalizada de interfaces visuales en asistentes de inteligencia artificial para dispositivos móviles.

Colaboración técnica con Google y alcance de la actualización

Samsung ha desarrollado esta funcionalidad conjuntamente con Google, que proporciona los modelos de lenguaje y capacidades de inteligencia artificial generativa mediante su sistema Gemini. Según ha declarado Jay Kim, vicepresidente ejecutivo y responsable de Experiencia del Cliente en Samsung Electronics, esta incorporación tiene como objetivo ofrecer una experiencia de usuario más adaptada a los entornos y rutinas personales mediante una IA integrada con funciones de visión y comunicación.

La actualización, que se distribuye desde el 7 de abril, no requiere pagos adicionales y estará disponible únicamente para los modelos de la serie Galaxy S25. Para su uso, será necesario disponer de conexión a Internet, una cuenta compatible y cumplir con los requisitos de edad establecidos (mayores de 18 años), además de aceptar las condiciones de uso.

Limitaciones y disponibilidad

Aunque la compañía no ha especificado el listado de países donde estará activa la función, ha señalado que su disponibilidad dependerá de la región. Asimismo, se ha advertido que las respuestas generadas por Gemini Live deben ser verificadas por el usuario, ya que el sistema puede no ofrecer siempre información precisa. Esta advertencia apunta a la naturaleza aún probabilística de los modelos de inteligencia artificial utilizados, que pueden generar errores en el reconocimiento de imágenes o en la interpretación contextual.

Por el momento, no se ha confirmado si esta tecnología se extenderá a otras gamas de dispositivos Galaxy o si quedará limitada a los modelos más recientes. Tampoco se han anunciado planes para su integración con otras aplicaciones o servicios externos.

Impacto potencial en el diseño de asistentes personales

La introducción de Gemini Live en la serie Galaxy S25 marca un punto de inflexión en la evolución de los asistentes virtuales móviles. Al incorporar capacidades visuales en la interacción, Samsung amplía el alcance funcional de la IA en sus dispositivos, abriendo paso a modelos conversacionales que van más allá del texto o la voz.

La visión computacional aplicada a escenarios de uso doméstico o de consumo sugiere un enfoque hacia la personalización contextual, donde el dispositivo no solo responde a preguntas, sino que interpreta situaciones visuales para ofrecer recomendaciones adaptadas al entorno del usuario. Esta estrategia se alinea con los desarrollos actuales en inteligencia artificial generativa multimodal, uno de los ejes de innovación en la industria tecnológica.

A medida que aumente la adopción de estas herramientas, será relevante observar su impacto en la experiencia de usuario, la privacidad de los datos captados por la cámara y las implicaciones regulatorias en relación con el procesamiento visual en tiempo real.