Editor en La Ecuación Digital. Consultor de Innovación y Estrategia…

OpenAI ha anunciado el lanzamiento de sus nuevos modelos o3 y o4-mini, los cuales incorporan capacidades de razonamiento visual nativas dentro de su serie o. Esta evolución permite a los modelos no solo interpretar imágenes, sino integrarlas directamente en su cadena de razonamiento, lo que representa un avance técnico respecto a modelos anteriores como el o1.

Los modelos o3 y o4-mini han sido diseñados para ejecutar procesos de razonamiento más extensos y complejos, integrando de forma fluida imágenes transformadas mediante herramientas internas. Esta capacidad incluye operaciones como recortes, ampliaciones y rotaciones, realizadas sin recurrir a sistemas especializados externos.

Según OpenAI, esta funcionalidad potencia la precisión en tareas de interpretación visual compleja y mejora la integración entre texto e imagen dentro de una única arquitectura de procesamiento.

Evaluación en benchmarks multimodales

OpenAI ha sometido a o3 y o4-mini a pruebas comparativas frente a sus predecesores y otros sistemas multimodales. Los nuevos modelos han mostrado mejoras notables en tareas que combinan razonamiento visual y textual. Destacan en evaluaciones como MathVista (resolución de problemas STEM), CharXiv (lectura e interpretación de gráficos), VLMs Are Blind (evaluación de percepción visual), y V* (búsqueda visual).

En el benchmark V*, el modelo alcanzó una precisión del 95,7 %, una cifra que indica una resolución casi completa del conjunto de tareas propuesto. Estas métricas consolidan a o3 y o4-mini como referencia actual en modelos de percepción y razonamiento multimodal.

Razonamiento visual como eje central

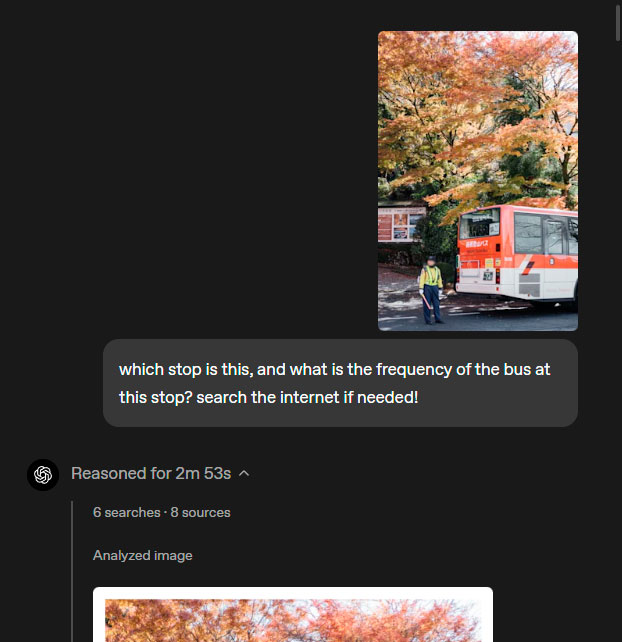

Una de las características diferenciales de estos modelos es la posibilidad de “pensar con imágenes”. Esta capacidad permite al sistema manipular elementos visuales durante la generación de respuestas, facilitando el análisis de información incluso cuando el contenido está incompleto, distorsionado o mal orientado.

Por ejemplo, al recibir una imagen con texto desalineado o múltiples elementos superpuestos —como un conjunto de problemas matemáticos en una fotografía—, los modelos son capaces de identificar, reorganizar y analizar cada elemento visual de manera autónoma, sin necesidad de que el usuario intervenga en la preparación del material.

Este enfoque introduce una nueva dimensión en el escalado de cálculo durante la inferencia, al fusionar razonamiento textual con interpretación visual sin depender de navegación por internet o procesamiento externo. Además, se integran con herramientas complementarias como análisis de datos mediante Python, búsqueda web o generación de imágenes para resolver problemas multidimensionales.

Limitaciones técnicas actuales

Pese a los avances, los modelos presentan algunas limitaciones. En primer lugar, el uso de cadenas de razonamiento extensas puede derivar en redundancias operativas, incluyendo manipulaciones visuales innecesarias. Asimismo, persisten errores de percepción en los que la interpretación visual inicial puede ser incorrecta, afectando al resultado final incluso cuando el uso de herramientas ha sido técnicamente adecuado.

Otro aspecto detectado es la variabilidad en el enfoque de razonamiento ante una misma entrada. Diferentes intentos de resolver un problema pueden producir cadenas de pensamiento dispares, no todas igualmente válidas o eficaces.

Perspectivas para el desarrollo multimodal

Los modelos o3 y o4-mini constituyen una evolución hacia agentes multimodales capaces de operar de manera autónoma sobre texto e imagen con una lógica compartida. Aunque todavía se afinan los mecanismos internos para reducir la redundancia y aumentar la fiabilidad, el paso hacia una integración visual nativa sin dependencias externas marca un cambio significativo en el diseño de arquitecturas de inteligencia artificial.

Desde OpenAI se ha anunciado la continuidad en la investigación sobre razonamiento multimodal, así como la mejora progresiva del procesamiento visual para que los modelos ofrezcan respuestas más concisas y coherentes.