Editor en La Ecuación Digital. Consultor de Innovación y Estrategia…

OpenAI ha presentado oficialmente sus nuevos modelos de lenguaje o3 y o4-mini , los más avanzados desarrollados hasta la fecha por la compañía.

Ambos modelos, que ya están disponibles en ChatGPT y mediante API para desarrolladores, incorporan capacidades extendidas de razonamiento y un acceso completo a herramientas como búsqueda web, análisis de archivos, generación de imágenes y procesamiento visual, lo que refuerza su utilidad en tareas complejas tanto académicas como empresariales.

Modelos diseñados para tareas de razonamiento complejas

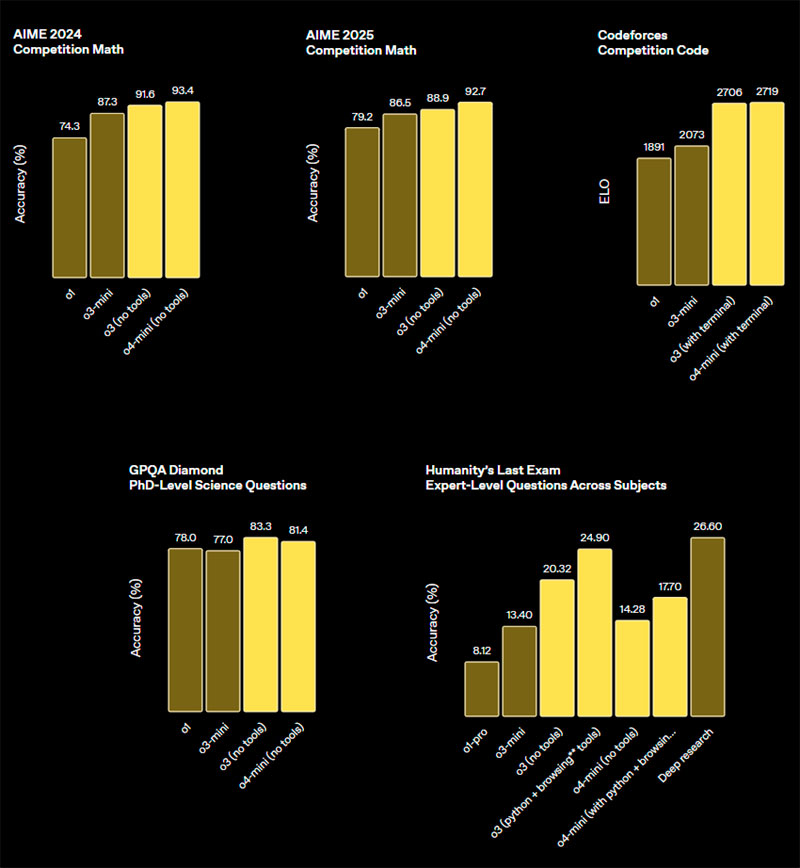

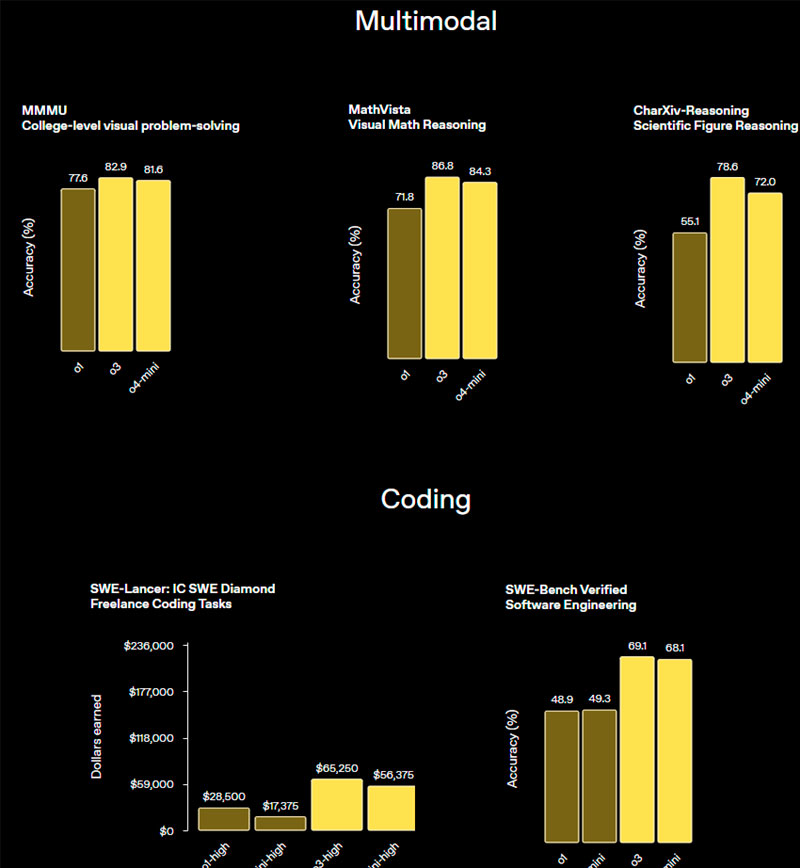

El modelo OpenAI o3 se presenta como el sistema más potente desarrollado por la compañía hasta la fecha. Está optimizado para tareas que requieren razonamiento avanzado en áreas como programación, matemáticas, ciencias y percepción visual. Según OpenAI, este modelo ha establecido nuevos estándares en benchmarks como Codeforces, SWE-bench (sin necesidad de estructuras personalizadas) y MMMU. También ha mostrado una reducción del 20 % en errores graves en comparación con su predecesor, el modelo o1, en evaluaciones realizadas por expertos independientes.

En paralelo, el modelo o4-mini ha sido diseñado como una alternativa más ligera y eficiente, ofreciendo un rendimiento competitivo en tareas de razonamiento a menor coste computacional. Destaca en evaluaciones como AIME 2024 y 2025, y supera a versiones anteriores como o3-mini en áreas STEM y no STEM, incluyendo ciencia de datos.

En los benchmarks de matemáticas y programación, el modelo o4-mini alcanzó un 99 % de precisión en AIME utilizando herramientas, mientras que o3 superó los 2700 puntos en Codeforces, posicionándose entre los 200 primeros del mundo.

Razonamiento multimodal y uso estratégico de herramientas

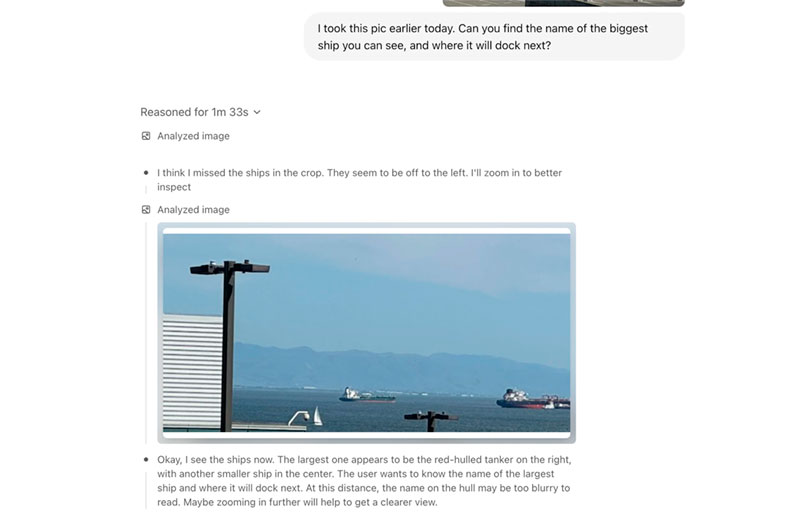

Una novedad destacada es que estos modelos no solo integran herramientas, sino que las utilizan de forma autónoma como parte de su proceso de pensamiento. Durante su entrenamiento, se les enseñó a razonar sobre cuándo y cómo emplearlas. En algunos casos, el modelo o3 llegó a realizar más de 600 llamadas a herramientas encadenadas para resolver un problema.

Estas capacidades permiten, por ejemplo, subir un póster científico incompleto y pedirle al modelo que complete el análisis, identifique el método de cálculo adecuado, lo compare con literatura reciente y elabore una conclusión. En otro caso documentado, el modelo exploró y corrigió un error en un repositorio real de código Python, usando terminal y herramientas estándar, todo dentro de un entorno de ejecución virtual.

Además, ambos modelos manejan razonamiento multimodal. Esto incluye interpretar imágenes, manipularlas con Python (recortes, transformaciones, rotaciones) y combinarlas con datos textuales para resolver problemas. Esta funcionalidad permite interpretar contenidos incluso si están borrosos, invertidos o en baja calidad.

En benchmarks especializados como GPQA (preguntas de nivel doctoral), MMU, MathVista, ChartQA y V-Star, los modelos demostraron un rendimiento significativamente superior al de versiones previas. Estas mejoras reflejan un avance técnico impulsado por una nueva fase de escalado en algoritmos de refuerzo por aprendizaje, con más de diez veces la capacidad de entrenamiento utilizada en el modelo o1.

Ejemplos de aplicación: desde ciencia hasta personalización

Los investigadores de OpenAI han destacado también casos concretos de uso. En un entorno de investigación, el modelo fue capaz de asistir en la demostración de un teorema en física de materia condensada. En otros contextos más cotidianos, los modelos pueden utilizar su memoria para personalizar contenidos. Por ejemplo, identificando intereses del usuario, combinando noticias recientes con datos de preferencia personal y generando automáticamente contenido como borradores de blogs con visualizaciones y citas verificables.

Este tipo de aplicaciones ilustra el avance hacia modelos con comportamiento de agente inteligente, capaces de tomar decisiones, consultar fuentes, generar resultados y presentarlos de forma estructurada, incluso si las instrucciones iniciales son generales o ambiguas.

Seguridad reforzada y control del uso de herramientas

OpenAI ha rediseñado su enfoque de entrenamiento en seguridad para los modelos o3 y o4-mini. Se han introducido nuevos conjuntos de datos orientados a fortalecer las capacidades de rechazo ante peticiones peligrosas, como la generación de malware o contenidos relacionados con riesgos biológicos. Además, se ha implementado un sistema de monitorización LLM basado en especificaciones interpretables, capaz de detectar con una tasa de acierto del 99 % conversaciones con contenido sensible, según los resultados de campañas internas de pruebas con humanos.

Ambos modelos han sido evaluados bajo el marco de preparación de OpenAI, que analiza capacidades potencialmente riesgosas en tres ámbitos: biología y química, ciberseguridad y auto-mejora de la IA. Los resultados, publicados en la tarjeta del sistema correspondiente, indican que tanto o3 como o4-mini permanecen por debajo del umbral «alto» de riesgo en las tres categorías.

Disponibilidad y acceso para usuarios y desarrolladores

Los modelos o3, o4-mini y o4-mini-high están ya disponibles para usuarios de los planes ChatGPT Plus, Pro y Team, reemplazando a las versiones anteriores o1, o3-mini y o3-mini-high. Está previsto que usuarios de ChatGPT Enterprise y ChatGPT Edu accedan a ellos en el plazo de una semana. Para los usuarios gratuitos, se ofrece la posibilidad de probar o4-mini a través de la función “Think” al componer una consulta.

En el entorno de desarrollo, ambos modelos están accesibles desde hoy mediante la Chat Completions API y la Responses API. Esta última soporta características avanzadas como resúmenes de razonamiento, persistencia de tokens en llamadas a funciones y, próximamente, herramientas integradas como búsqueda web o ejecución de código.

Codex CLI y programa de apoyo a desarrolladores

Junto al lanzamiento de los nuevos modelos, OpenAI ha anunciado Codex CLI, una herramienta experimental que permite interactuar con sus modelos desde la terminal. Esta interfaz ligera está pensada para tareas de programación que combinan razonamiento multimodal, como interpretar capturas de pantalla o bocetos combinados con código local. Codex CLI está disponible como proyecto de código abierto en GitHub.

Además, se ha abierto una convocatoria con un fondo de un millón de dólares para financiar proyectos que utilicen Codex CLI y modelos de OpenAI. Las propuestas pueden recibir créditos de API en tramos de 25.000 dólares.

Escalabilidad mediante aprendizaje por refuerzo

Durante el entrenamiento del modelo o3, OpenAI ha confirmado que el patrón de mejora por escala observado en el preentrenamiento de modelos GPT se reproduce también en el aprendizaje por refuerzo a gran escala. Según la empresa, permitir que los modelos razonen durante más tiempo con mayor capacidad computacional sigue generando mejoras de rendimiento significativas.

Esta técnica también se ha aplicado al uso de herramientas, entrenando a los modelos no solo para ejecutarlas, sino para razonar estratégicamente sobre cuándo usarlas según el resultado deseado. Esta capacidad resulta especialmente útil en situaciones abiertas que requieren razonamiento visual y flujos de trabajo secuenciales.

Avance hacia modelos más agénticos y autónomos

Con la introducción de los modelos o3 y o4-mini, OpenAI establece una línea evolutiva en la que convergen la potencia de razonamiento especializada de la serie “o” con las capacidades conversacionales y de herramientas de la serie GPT. Este enfoque permite el desarrollo de modelos más autónomos, capaces de ejecutar tareas complejas en distintos dominios, desde investigación científica hasta generación de contenido personalizado, sin intervención constante del usuario.