Editor en La Ecuación Digital. Consultor de Innovación y Estrategia…

NVIDIA ha anunciado la ampliación de su plataforma de centros de datos para inteligencia artificial con la introducción de Blackwell Ultra , una evolución de su arquitectura Blackwell destinada a responder a la creciente demanda de procesamiento en tareas de inferencia y razonamiento de IA.

Esta actualización, según ha detallado la compañía durante su presentación, incluye mejoras sustanciales en capacidad de cálculo, escalabilidad en entornos de entrenamiento y postentrenamiento, así como en rendimiento para aplicaciones que requieren razonamiento, agentes autónomos y simulaciones físicas complejas.

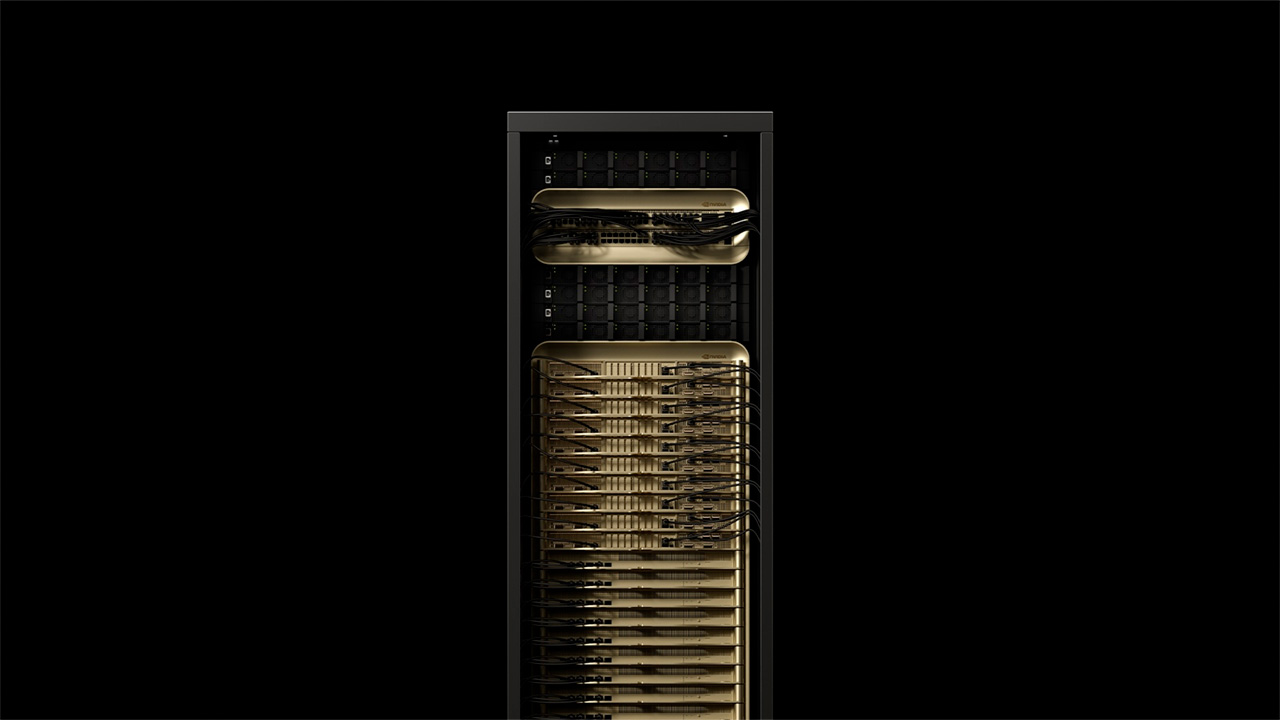

El sistema GB300 NVL72, pieza central de esta arquitectura, integra 72 GPUs Blackwell Ultra y 36 CPUs Grace basadas en la arquitectura Arm Neoverse, en un diseño a escala de rack que actúa como una única unidad de procesamiento masivo. Este sistema ofrece un rendimiento de inferencia 1,5 veces superior al del modelo anterior, GB200 NVL72, y, según datos de la propia empresa, multiplica por 50 el potencial de ingresos por infraestructura en comparación con sistemas basados en la generación Hopper. Fuente: NVIDIA.

Blackwell Ultra y la inferencia escalada en la era del razonamiento de IA

Uno de los avances que destaca NVIDIA es la capacidad del sistema GB300 NVL72 para realizar inferencia escalada, una técnica que permite aplicar más potencia de cálculo durante la fase de inferencia para aumentar la precisión de las respuestas generadas por los modelos. Este enfoque, especialmente relevante en tareas de razonamiento, facilita que los modelos descompongan instrucciones complejas en múltiples etapas, evaluando soluciones alternativas antes de emitir una respuesta.

NVIDIA también ha anunciado el sistema HGX B300 NVL16, que, en comparación con la arquitectura Hopper, proporciona una inferencia 11 veces más rápida en modelos de lenguaje de gran tamaño (LLM), junto con una memoria cuatro veces mayor y una capacidad de cálculo siete veces superior. Estas características están orientadas a ejecutar cargas de trabajo que requieren planificación iterativa, resolución multietapa y simulación en entornos físicos virtuales.

La plataforma será integrada en servicios como NVIDIA DGX Cloud y DGX SuperPOD, que ofrecen un entorno gestionado de principio a fin para entrenamiento, despliegue y operación de modelos de IA de alto rendimiento en la nube, empleando la arquitectura Blackwell como núcleo.

Infraestructura de red y escalado para fábricas de IA

La infraestructura Blackwell Ultra se complementa con sistemas de red de alto rendimiento como NVIDIA Spectrum-X, que incorpora conectividad Ethernet de 800 Gb/s por GPU y funcionalidades avanzadas de acceso remoto a memoria (RDMA) a través de las tarjetas ConnectX-8 SuperNIC. Esta configuración permite minimizar la latencia y el jitter, factores críticos en la inferencia de modelos de gran escala.

Además, los sistemas Blackwell Ultra integran unidades de procesamiento de datos BlueField-3 DPU, que permiten la segmentación multitenant de la red, el acceso acelerado a datos, la elasticidad de los recursos de GPU y la detección de amenazas de ciberseguridad en tiempo real.

Plataforma de software y herramientas de inferencia optimizadas

Conjuntamente con el nuevo hardware, NVIDIA ha presentado NVIDIA Dynamo, un software de inferencia de código abierto orientado a maximizar el rendimiento y reducir los costes de operación de modelos de razonamiento. Dynamo permite desagregar las fases de procesamiento y generación de los modelos, optimizando de forma independiente cada etapa. Esta estructura distribuye el cálculo entre miles de GPUs y coordina la inferencia en tiempo real con el objetivo de reducir los tiempos de respuesta y mejorar la eficiencia operativa.

La solución está diseñada para facilitar el despliegue de modelos como NVIDIA Llama Nemotron Reason, así como marcos operativos desarrollados dentro de la plataforma NVIDIA AI Enterprise, que incluye microservicios NIM, bibliotecas CUDA-X y herramientas especializadas para entornos de nube, centros de datos y estaciones de trabajo.

Alianzas estratégicas con fabricantes y proveedores de nube

NVIDIA ha confirmado que diversos fabricantes de servidores comenzarán a ofrecer sistemas basados en la arquitectura Blackwell Ultra a partir del segundo semestre de 2025. Entre los socios se encuentran Cisco, Dell Technologies, Hewlett Packard Enterprise, Lenovo y Supermicro, junto con otros proveedores como Foxconn, GIGABYTE, Pegatron, Quanta Cloud Technology y Wiwynn.

Asimismo, plataformas de servicios en la nube como Amazon Web Services, Google Cloud, Microsoft Azure y Oracle Cloud Infrastructure, junto con proveedores especializados en GPU como CoreWeave, Lambda o Crusoe, integrarán instancias impulsadas por Blackwell Ultra en sus respectivas infraestructuras.

Uso industrial de la IA en entornos complejos

Las capacidades presentadas están especialmente dirigidas a sectores donde la IA debe ejecutar razonamientos complejos y tomar decisiones autónomas. Es el caso de la llamada IA agente, que no se limita a seguir instrucciones sino que es capaz de planificar, iterar y ejecutar acciones hacia objetivos definidos, y de la IA física, empleada en la generación de datos sintéticos fotorealistas en tiempo real, útil en el entrenamiento de vehículos autónomos, robots o sistemas de simulación industrial.

Estas aplicaciones requieren una combinación de potencia de cálculo, reducción de latencia, escalabilidad de red y capacidad de inferencia en tiempo real, ámbitos en los que la nueva arquitectura pretende posicionarse como solución de referencia.