Editor en La Ecuación Digital. Consultor de Innovación y Estrategia…

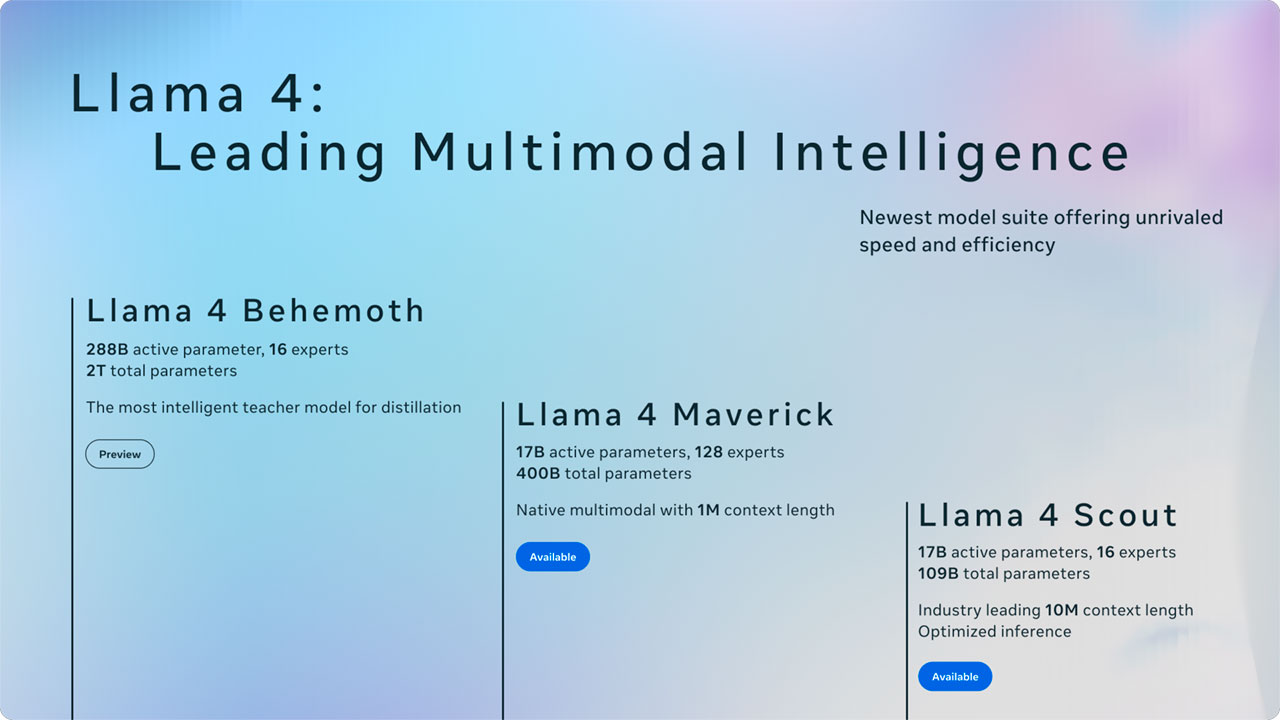

Meta ha anunciado el lanzamiento de los primeros modelos de la serie Llama 4 , una nueva generación de sistemas de inteligencia artificial con capacidad multimodal nativa, arquitectura Mixture-of-Experts (MoE) y pesos abiertos. Esta familia incluye los modelos Llama 4 Scout, Llama 4 Maverick y una vista preliminar de Llama 4 Behemoth, un modelo de entrenamiento de gran escala con más de dos billones de parámetros totales. Fuente: Meta.

Ambos modelos ya disponibles, Scout y Maverick, cuentan con 17.000 millones de parámetros activos, aunque presentan arquitecturas distintas: el primero emplea 16 expertos y el segundo, 128. Según los datos compartidos por Meta, Llama 4 Maverick supera en rendimiento a modelos como GPT-4o y Gemini 2.0 Flash en pruebas de codificación y razonamiento, mientras que Llama 4 Scout destaca por su eficiencia y capacidad de contexto, alcanzando los 10 millones de tokens, una cifra sin precedentes en su categoría.

Llama 4 Scout y Maverick: características técnicas

Llama 4 Scout es un modelo compacto diseñado para funcionar con una única GPU NVIDIA H100. Incorpora una arquitectura MoE de 16 expertos y un total de 109.000 millones de parámetros. Su ventana de contexto de 10 millones de tokens lo posiciona como un modelo idóneo para tareas que requieren procesamiento de grandes volúmenes de texto o código, como la lectura y análisis de múltiples documentos o la personalización de tareas mediante historiales extensos.

Por su parte, Llama 4 Maverick mantiene el mismo número de parámetros activos (17.000 millones), pero aumenta el número de expertos a 128 y eleva el total de parámetros a 400.000 millones. El modelo combina capas densas y MoE para mejorar la eficiencia durante la inferencia, y se ejecuta en un único host H100 o en configuración distribuida para entornos de producción.

Meta afirma que Llama 4 Maverick presenta una relación rendimiento-coste superior en su clase y ha logrado una puntuación ELO de 1417 en el benchmark LMArena para versiones experimentales orientadas a chat.

Multimodalidad e infraestructura de entrenamiento

La serie Llama 4 está diseñada desde su núcleo para ser nativamente multimodal, lo que implica que puede procesar texto, imágenes y vídeo de forma integrada gracias a un esquema de fusión temprana (early fusion). Meta ha mejorado el codificador visual basado en MetaCLIP, adaptado al modelo lingüístico mediante entrenamiento conjunto con el modelo congelado.

Ambos modelos han sido preentrenados con datos multilingües en más de 200 idiomas, con más de 100 idiomas representados por al menos 1.000 millones de tokens cada uno. En total, el volumen de datos asciende a más de 30 billones de tokens, incluyendo textos, imágenes y vídeos.

Para garantizar eficiencia, el preentrenamiento de Llama 4 Behemoth —el modelo profesor— se llevó a cabo en precisión FP8 utilizando 32.000 GPUs, alcanzando 390 TFLOPs por GPU. Este modelo MoE cuenta con 288.000 millones de parámetros activos y 2 billones de parámetros totales, y ha servido como base para la destilación de Scout y Maverick mediante una técnica propia de Meta basada en pérdidas mixtas dinámicamente ponderadas.

Nuevas estrategias de entrenamiento y optimización

El proceso de entrenamiento de Llama 4 ha incorporado técnicas avanzadas en las fases de ajuste posterior, incluyendo:

-

Fine-tuning supervisado ligero (SFT)

-

Aprendizaje por refuerzo online (RL)

-

Optimización directa por preferencias (DPO)

Uno de los retos principales ha sido equilibrar el rendimiento entre modalidades, capacidad de razonamiento y habilidades conversacionales. Para ello, se descartaron más del 50% de los datos etiquetados como “fáciles” y se utilizó un conjunto más exigente para el ajuste. El aprendizaje por refuerzo se ejecutó con prompts seleccionados por dificultad creciente y filtros dinámicos de datos sin ventaja aparente.

Estos métodos han resultado en mejoras notables en precisión y coherencia en tareas como codificación, comprensión visual y razonamiento lógico.

Seguridad, evaluación de riesgos y mitigación de sesgos

Meta ha incorporado salvaguardas en todas las etapas del ciclo de desarrollo. A nivel de sistema, ha desplegado herramientas como:

-

Llama Guard, un modelo para la detección de entradas y salidas riesgosas.

-

Prompt Guard, especializado en la identificación de ataques tipo jailbreak e inyecciones de prompt.

-

CyberSecEval, un conjunto de pruebas diseñado para evaluar la exposición a riesgos de ciberseguridad en modelos generativos.

Además, ha desarrollado un nuevo método de pruebas automatizadas llamado GOAT (Generative Offensive Agent Testing), que simula ataques por actores de habilidad media en interacciones multi-turno. Esta técnica ha permitido mejorar la cobertura y eficacia de las pruebas de robustez.

En cuanto a la reducción de sesgos, los modelos Llama 4 han sido afinados para reducir respuestas politizadas o sesgadas. Según las evaluaciones internas, el índice de rechazo de respuestas en temas sociales o políticos ha bajado del 7% al 2% respecto a Llama 3.3, y el porcentaje de rechazos desequilibrados se ha reducido a menos del 1%.

Disponibilidad y ecosistema

Los modelos Llama 4 Scout y Maverick están disponibles para descarga en llama.com y Hugging Face, y próximamente se integrarán en servicios cloud, hardware perimetral y plataformas de terceros. Asimismo, ya pueden probarse a través de Meta AI en WhatsApp, Messenger, Instagram Direct y el sitio web de Meta.

Llama 4 se posiciona como una infraestructura abierta que permite a desarrolladores y empresas construir soluciones avanzadas sobre una base multimodal potente y escalable. Con vistas al futuro, Meta presentará más detalles sobre su hoja de ruta durante el evento LlamaCon el próximo 29 de abril.

Perspectivas futuras para modelos de gran escala

La introducción del modelo Llama 4 Behemoth señala un cambio en la escala de entrenamiento de modelos de lenguaje. Con 2 billones de parámetros totales, Behemoth ha requerido el rediseño completo de las infraestructuras de aprendizaje por refuerzo. La compañía ha implementado una arquitectura de entrenamiento asincrónico y paralelo, logrando un incremento de 10 veces en eficiencia frente a generaciones anteriores.

El modelo está orientado a tareas de razonamiento, codificación y comprensión multilingüe y multimodal, y ha sido fundamental en la formación indirecta de modelos más pequeños y accesibles. Aunque aún no está disponible para descarga, representa el eje estratégico de la familia Llama 4.