Editor en La Ecuación Digital. Consultor de Innovación y Estrategia…

En el marco de la Conferencia Internacional de Supercomputación (ISC) de 2021, Intel ha mostrado cómo la compañía está ampliando su liderazgo en la computación de alto rendimiento (HPC, por sus siglas en inglés) con una serie de apuestas tecnológicas, asociaciones y adopción por parte de los clientes.

Los procesadores Intel son la arquitectura de computación más utilizada en los superordenadores de todo el mundo, lo que permite realizar descubrimientos médicos y avances científicos a nivel internacional. Intel anuncia avances en su procesador Xeon para HPC e inteligencia artificial (IA, por sus siglas en inglés), así como innovaciones en memoria, software, almacenamiento de clase a exaescala y tecnologías de red para un conjunto de casos de uso de HPC.

«Para maximizar el rendimiento de la HPC debemos aprovechar todos los recursos informáticos y los avances tecnológicos de los que disponemos», afirma Trish Damkroger, vice president and general manager of High Performance Computing en Intel. «Intel es el motor del movimiento del sector hacia la computación a exaescala y los avances que estamos ofreciendo con nuestras CPU, XPU, oneAPI Toolkits, almacenamiento DAOS de clase exaescala y redes de alta velocidad nos están acercando a nuestros objetivos».

Avance en el liderazgo del rendimiento de la HPC

A principios de este año, Intel amplió su posición de liderazgo en HPC con el lanzamiento de los procesadores escalables Intel Xeon de tercera generación. El último procesador ofrece hasta un 53% más de rendimiento frente al procesador de la generación anterior en una serie de cargas de trabajo de HPC, como en ciencias biológicas, servicios financieros y fabricación.

En comparación con su competidor x86 más cercano, el procesador escalable Intel Xeon de tercera generación ofrece un mejor rendimiento en una serie de cargas de trabajo de HPC populares. Por ejemplo, cuando se compara un procesador escalable Xeon 8358 con un procesador AMD EPYC 7543, el rendimiento de NAMD es un 62 % superior, el de LAMMPS es un 57 % superior, el de RELION es un 68 % superior y el de Binomial Options, un 37 % superior.

Además, las simulaciones Monte Carlo se ejecutan más de dos veces más rápido, lo que permite a las empresas financieras obtener resultados de precios en la mitad de tiempo. Los procesadores escalables Xeon 8380 también superan a los procesadores AMD EPYC 7763 en las principales cargas de trabajo de IA, con un rendimiento un 50% superior en 20 benchmarks comunes.

Entre los laboratorios de HPC, los centros de supercomputación, las universidades y los fabricantes de equipos originales que han adoptado la última plataforma de computación de Intel se encuentran Dell Technologies, HPE, Korea Meteorological Administration, Lenovo, Max Planck Computing and Data Facility, Oracle, la Universidad de Osaka y la Universidad de Tokio.

Integración de la memoria de gran ancho de banda en los procesadores escalables Intel Xeon de última generación

Las cargas de trabajo como el modelado y la simulación (por ejemplo, la dinámica de fluidos computacional, la previsión climática y meteorológica, la cromodinámica cuántica…), la inteligencia artificial (por ejemplo, el entrenamiento y la inferencia del deep learning), la analítica (por ejemplo, la analítica de big data), las bases de datos en memoria, el almacenamiento y otros impulsan los avances científicos.

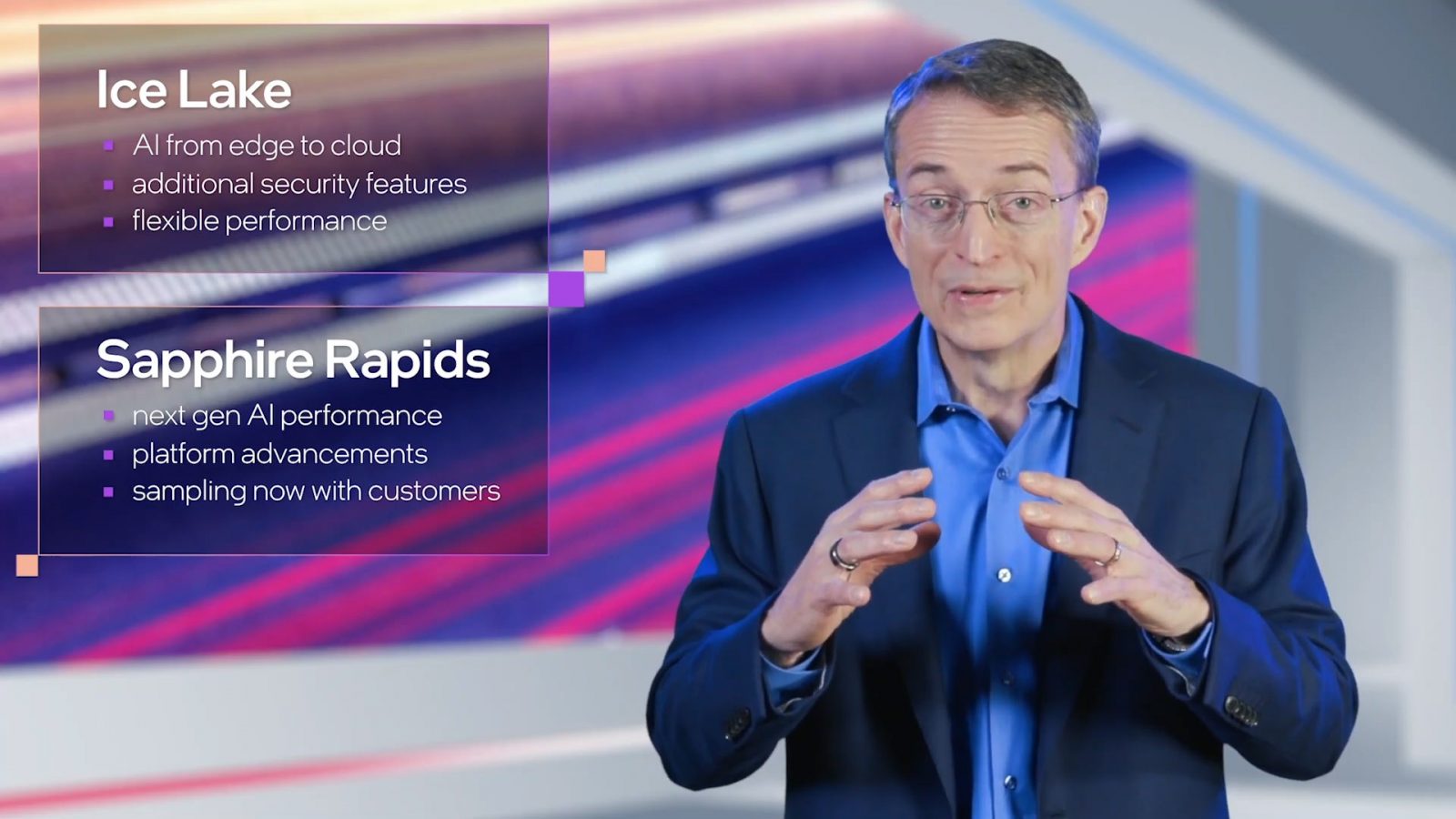

La próxima generación de procesadores escalables Intel Xeon (cuyo nombre en clave es «Sapphire Rapids») ofrecerá memoria de alto ancho de banda (HBM, por sus siglas en inglés) integrada, lo que proporcionará un aumento espectacular del ancho de banda de la memoria y una mejora significativa del rendimiento para las aplicaciones HPC que operan con cargas de trabajo sensibles al ancho de banda de la memoria. Los usuarios pueden potenciar las cargas de trabajo utilizando solo la memoria de alto ancho de banda o en combinación con una DDR5.

Los procesadores Sapphire Rapids con HBM integrada gozan de una acogida excelente por parte de los clientes, con resultados positivos tempranos, como el superordenador Aurora del Departamento de Energía de EE. UU. en el Laboratorio Nacional de Argonne y el superordenador Crossroads en el Laboratorio Nacional de Los Álamos.

«Conseguir resultados a exaescala requiere un acceso y un procesamiento rápidos de cantidades masivas de datos», afirma Rick Stevens, associate laboratory director of Computing, Environment and Life Sciences del Laboratorio Nacional de Argonne. «La integración de la memoria de gran ancho de banda en los procesadores escalables Intel Xeon aumentará de manera significativa el ancho de banda de la memoria de Aurora y nos permitirá aprovechar la potencia de la inteligencia artificial y el análisis de datos para realizar simulaciones avanzadas y modelado en 3D».

Charlie Nakhleh, associate laboratory director for Weapons Physics del Laboratorio Nacional de Los Álamos, afirmó que: «el superordenador Crossroads de los Laboratorios Nacionales de Los Álamos está diseñado para avanzar en el estudio de sistemas físicos complejos para la ciencia y la seguridad nacional. La nueva generación de procesadores Xeon Sapphire Rapids de Intel, junto con la memoria de alto ancho de banda, mejorará de forma notoria el rendimiento de las cargas de trabajo que requieren mucha memoria en nuestro sistema Crossroads. [Sapphire Rapids con HBM] acelera los mayores cálculos complejos de física e ingeniería, permitiéndonos completar tareas importantes de investigación y desarrollo en materia de seguridad global, tecnologías energéticas y competitividad económica».

La plataforma basada en Sapphire Rapids proporcionará capacidades únicas para acelerar la HPC, así como un mayor ancho de banda de E/S con PCI express 5.0 (comparado con PCI express 4.0) y soporte de Compute Express Link (CXL) 1.1, lo que permite casos de uso avanzados en computación, redes y almacenamiento.

Además de los avances en materia de memoria y E/S, Sapphire Rapids está optimizado para cargas de trabajo de HPC e inteligencia artificial (IA), con un nuevo motor de aceleración de IA integrado llamado Intel® Advanced Matrix Extensions (AMX). Intel AMX está diseñado para ofrecer un aumento significativo del rendimiento para la inferencia y el entrenamiento del deep learning. Entre los clientes que ya trabajan con Sapphire Rapids se encuentran CINECA, el Centro de Supercomputación de Leibniz (LRZ) y el Laboratorio Nacional de Argonne, así como los equipos del sistema Crossroads del Laboratorio Nacional de Los Álamos y el Laboratorio Nacional de Sandia.

Puesta en marcha de la GPU Intel Xe-HPC (Ponte Vecchio)

A principios de este año, Intel puso en marcha su GPU basada en Xe-HPC (cuyo nombre en clave es «Ponte Vecchio») y está en proceso de validación del sistema. Ponte Vecchio es una GPU basada en la arquitectura Xe optimizada para cargas de trabajo de HPC e IA. Aprovechará la tecnología de empaquetado 3D Foveros de Intel para integrar múltiples IP en el paquete, incluida la memoria HBM y otra propiedad intelectual. La GPU cuenta con una arquitectura de computación, memoria y estructura para satisfacer las necesidades de los superordenadores más avanzados del mundo, como Aurora.

Ponte Vecchio estará disponible en un factor de forma y subsistemas de módulo OAM (OCP Accelerator Module), que servirá para las capacidades de ampliación y reducción de escala necesarias para las aplicaciones de HPC.

Ampliación de la Ethernet de Intel para HPC

En la ISC de 2021, Intel también presenta su nueva solución de redes de alto rendimiento con Ethernet (HPN, por sus siglas en inglés), que amplía las capacidades de la tecnología Ethernet para clústeres más pequeños en el segmento de la computación de alto rendimiento mediante el uso de adaptadores y controladores de red estándar de la serie Intel Ethernet 800, conmutadores basados en ASIC de conmutadores Ethernet programables Intel® Tofino™ P4 y el software Intel® Ethernet Fabric suite. HPN permite un rendimiento de las aplicaciones comparable al de InfiniBand a un coste menor, aprovechando al mismo tiempo la facilidad de uso que ofrece Ethernet.

Soporte comercial para DAOS

Intel está introduciendo soporte comercial para DAOS (almacenamiento distribuido de objeto de aplicación), un almacén de objetos definido por un software de código abierto construido para optimizar el intercambio de datos en las arquitecturas Intel HPC. DAOS es la base del stack de almacenamiento Intel® Exascale, anunciada previamente por el Laboratorio Nacional Argonne y que ya están utilizando clientes de Intel como LRZ y JINR (Instituto Conjunto de Investigación Nuclear).

El soporte de DAOS está ahora disponible para los socios como una oferta de soporte L3, lo que les permite proporcionar una solución completa de almacenamiento integral en combinación con sus servicios. Además de los propios bloques de construcción de centros de datos de Intel, entre los primeros socios de este nuevo soporte comercial se encuentran HPE, Lenovo, Supermicro, Brightskies, Croit, Nettrix, Quanta y RSC Group.